AI 大模型算力爆炸:DeepSeek 带来的数据中心机遇与挑战(一)

一、数据中心技术发展趋势

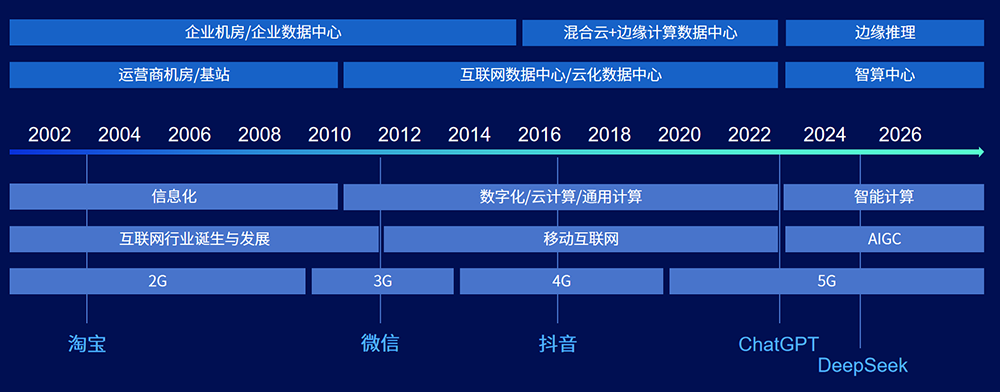

1. 中国数据中心行业发展历程

中国数据中心行业的发展可清晰地划分为信息化、数字化 / 云计算 / 通用计算、智能计算三个关键阶段,每个阶段都与网络技术迭代和产业需求升级紧密相连:- 2002 年 - 2010 年(信息化阶段):伴随 2G/3G 网络的兴起,互联网行业应运而生并快速发展。这一时期,以阿里淘宝为代表的电商平台蓬勃成长,极大地推动了对运营商机房、基站、企业机房及企业数据中心的需求,数据中心建设进入初步扩张期。

- 2010 年 - 2022 年(数字化 / 云计算 / 通用计算阶段):3G/4G/5G 网络通信技术实现跨越式发展,移动互联网迎来爆发式增长。微信等移动社交软件、抖音等短视频平台顺势崛起,带动了互联网数据中心、云化数据中心的需求激增,同时混合云与边缘计算数据中心、企业机房及企业数据中心的需求也持续增长,数据中心向多元化、云化方向演进。

- 2022 年 - 2026 年(智能计算阶段):处于 5G 时代的 AIGC(生成式人工智能)浪潮席卷而来,ChatGPT、DeepSeek 等大模型不断涌现,边缘推理技术得到全面发展。这一阶段,数据中心的算力需求呈现指数级增长,智能计算成为行业发展的核心驱动力。

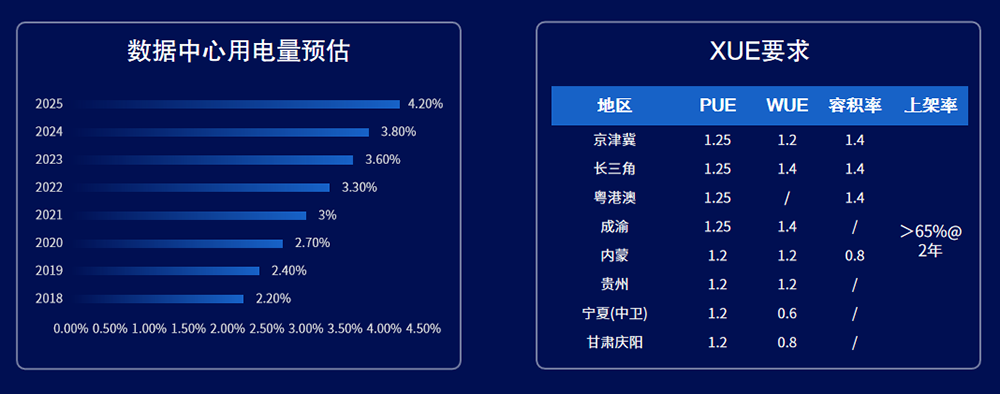

2. 节能低碳,数据中心的可持续发展之路

在 “双碳” 目标的引领下,数据中心正朝着节能低碳的可持续方向转型,具体体现在能源生产、消耗和管理三个层面:(1)能源生产低碳化

数据中心已从单纯的用能系统逐步升级为综合能源系统,积极拥抱绿色能源与储能技术:- 绿电应用:大规模引入光伏、风电等可再生能源,减少对传统化石能源的依赖,从能源源头降低碳排放。

- 储能技术:通过储能系统实现削峰填谷,提高能源利用效率,增强数据中心的能源韧性。

(2)能源消耗节约化

行业对数据中心能源利用效率的要求日益严苛,评价指标从最初的 PUE(电能利用效率)扩展到 WUE(水利用效率)和 CUE(碳利用效率),并通过多种措施实现 “四节”(节水、节电、节地、节材):- 架构极简:简化数据中心基础设施架构,减少不必要的能源损耗环节。

- 高效部件:采用高能效的服务器、制冷设备等核心部件,提升能源转化效率。

- 自然冷却:充分利用自然冷源(如冷空气、冷却水),降低机械制冷的能耗。

- 综合节约:在设计和运营中全面贯彻节水、节电、节地、节材的理念,实现资源的高效利用。

(3)能源管理智能化

数据中心的运营与维护正加速向数字化、智能化、无人化转型,以提升能源管理水平:- AI 加持:利用人工智能技术对能源消耗进行实时监测、分析和预测,优化能源分配。

- 无人运维:引入自动化运维设备和系统,减少人工干预,提高运维效率和准确性。

- 能效调优:通过智能算法动态调整设备运行状态,实现整体能效的持续优化。

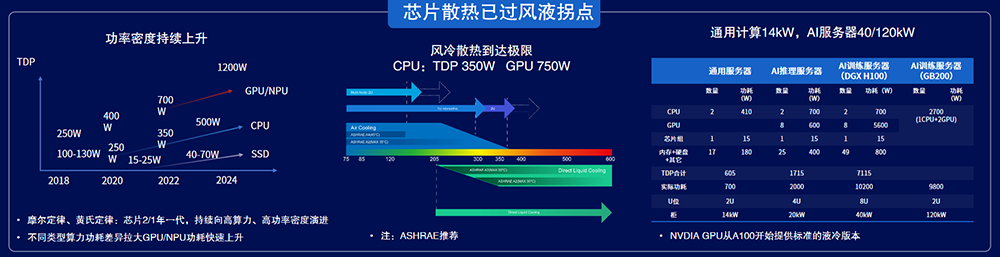

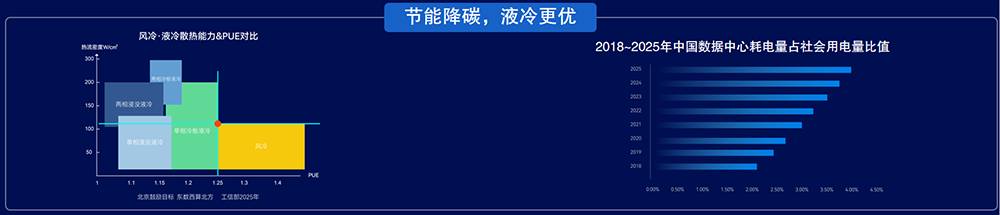

3. 高密散热,低碳节能,液冷是最优解

随着算力需求的爆发式增长,服务器功率密度持续攀升,从 2018 年的 100-130W 跃升至如今的 1200W,不同类型算力的功耗差异显著拉大,尤其是 GPU/NPU 的功耗增长迅猛。- 功耗差异:CPU 的 TDP(热设计功耗)已达 350W,GPU 更是高达 750W;通用服务器功率约为 700W,而 AI 训练服务器(如 GB200)则达到 9800W;单柜通用计算功率为 14kW,单柜 AI 服务器功率则为 40-120kW。

- 散热瓶颈与突破:传统的风冷散热技术已接近极限,难以满足高功率密度设备的散热需求。液冷技术凭借其高效的散热能力,成为实现低碳节能的最优解。从 PUE(电能利用效率)来看,风冷的 PUE 在 1.25-1.4 之间;而液冷技术中,单相冷板液冷的 PUE 为 1.2-1.25,两相冷板液冷为 1.15-1.2,单相浸没液冷为 1-1.15,两相浸没液冷则低至 0.5-1.15,显著优于风冷。

4. 新的行业格局 - 从数据中心到智算中心

随着人工智能的深入发展,数据中心的形态不断升级,逐渐形成了多元化的智算中心格局:- 超级计算中心:新增约 10 个,主要分布在郑州、成都、合肥、兰州等综合性国家科学中心,为重大科学研究提供强大算力支持。

- 智能计算中心:新增 10 个以上,有望达到数十个,集中在武汉、南京、西安、上海、深圳、北京等国家新一代人工智能创新发展试验区及国家人工智能创新应用先导区,聚焦人工智能相关的计算需求。

- 一体化大数据中心:规划了 8 大节点,10 多个数据中心集群分布在京津冀、粤港澳、长三角、成渝、内蒙、贵州、宁夏、甘肃等全国一体化大数据中心及国家算力枢纽节点,旨在实现全国算力的统筹调度和高效利用。

- 城市云脑 / 边缘数据中心:预计将建成数百个,住建部已试点 290 个智慧城市城市大脑,这类数据中心贴近用户端,为智慧城市、边缘计算等场景提供低时延算力支持。

5. 智算中心的挑战:弹性、TTM、高可靠、高可用

智算中心在发展过程中面临着多方面的挑战,需要在技术和运营模式上不断创新:- 业务多样性:涵盖通用计算、智算训练、智算推理等多种业务类型,对算力的需求差异较大。

- 服务器类型多样性:涉及 CPU、国产信创卡、NV 卡以及 L1 和 L2 耦合等多种服务器类型,增加了硬件管理的复杂性。

- 物理场景复杂性:需考虑风液比、气候条件、机房层数等物理因素对基础设施的影响。

- 基础设施要求:需满足绿色高效、高可靠 / 高可用、弹性部署、TTM(Time to Market,上市时间)短等要求,以快速响应业务需求并降低运营成本。

6. 数据中心关键评价指标达成路径

数据中心的关键评价指标 PUE(电能利用效率)的达成需要多环节协同优化,其计算公式为:1.20=1+0.11+0.07+0.02,即 PUE=IT 负载系数 + 制冷负载系数 CLF + 供电负载系数 PLF + 其他负载系数 OLF。各系数的优化路径如下:- 制冷负载系数 CLF:采用间接蒸发冷却、氟泵双擎、磁悬浮变频、液冷技术等高效制冷方案,降低制冷系统能耗。

- 供电负载系数 PLF:引入新型电力技术、创新电力模式、UPS 超级旁路等,提高供电系统的效率和可靠性。

- 其他负载系数 OLF:通过智能化控制、建筑节能管理等手段,减少其他环节的能源损耗。

- WUE(水利用效率):采用省水 / 无水节能解决方案,将 WUE 控制在≤1.6 的范围内。

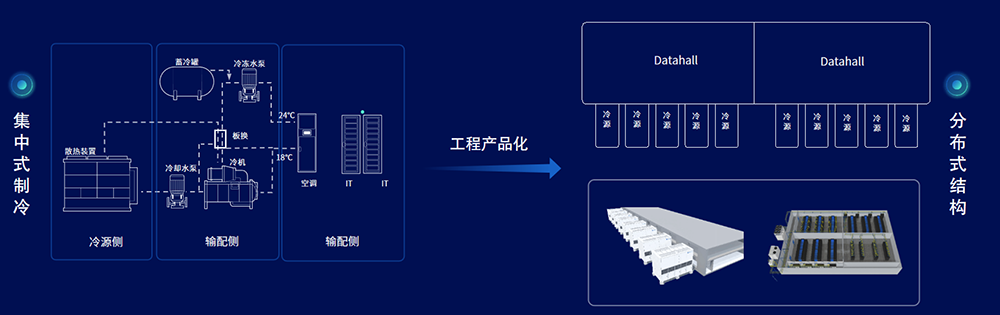

7. 分布式制冷架构 - 规、建、运、维全生命周期可控

相比传统的集中式制冷架构,分布式制冷架构在全生命周期管理中具有显著优势:- 集中式制冷:存在单点故障风险高且影响面广、管线设计复杂导致整体建设周期长(TTM>240 天)、同一系统分散供货使得运维人员专业要求高等问题。

- 分布式结构:

- 规划阶段:分布式架构使制冷系统更可靠,降低了单点故障的影响。

- 建设阶段:采用工厂预制化方式,大幅缩短 TTM 周期(TTM<90 天),加快数据中心的投产速度。

- 运营阶段:内置系统控制逻辑,可实现智能寻优运行,提升运营效率。

- 维护阶段:系统产品化,降低了对维护人员多领域专业知识的要求,便于维护管理。

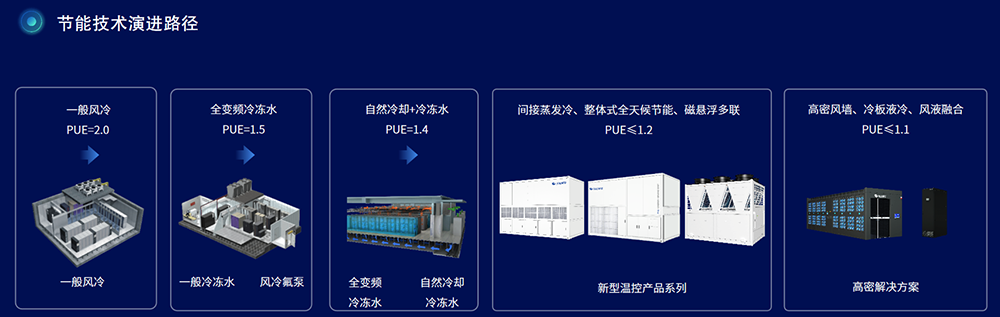

8. 制冷技术方案的发展方向

随着数据中心对节能和散热要求的提高,制冷技术方案不断升级,不同方案的 PUE 及特点如下:- 一般风冷:PUE=2.0,技术成熟但能效较低。

- 全变频冷冻水:PUE=1.5,结合了一般风冷和风冷氟泵技术,能效有所提升。

- 自然冷却 + 冷冻水:PUE=1.4,采用全变频 / 冷冻水与自然冷却 / 冷冻水结合的方式,具有可靠、稳定的特点,但维护量相对较多。

- 间接蒸发冷、整体式全天候节能、磁悬浮多联:PUE≤1.2,属于新型温控产品系列,具有高能效、低耗水、快速部署等优势。

- 高密风墙、冷板液冷、风液融合:PUE≤1.1,是高密解决方案,具备更高效、高密度、可靠、静音、洁净等特点,能满足高功率密度设备的散热需求。

获取最新价格?我们会尽快回复(12小时内)