双碳”趋势下,零碳数据中心如何打造,要重点考虑"电从哪里来?热到哪里去?"

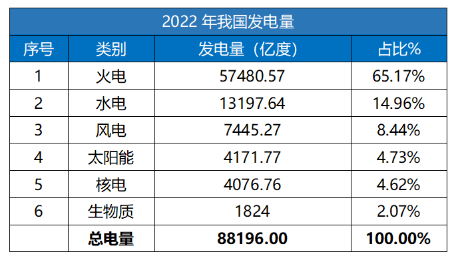

然后再对比来自国家能源局的2022年全国用电量数据,如下:

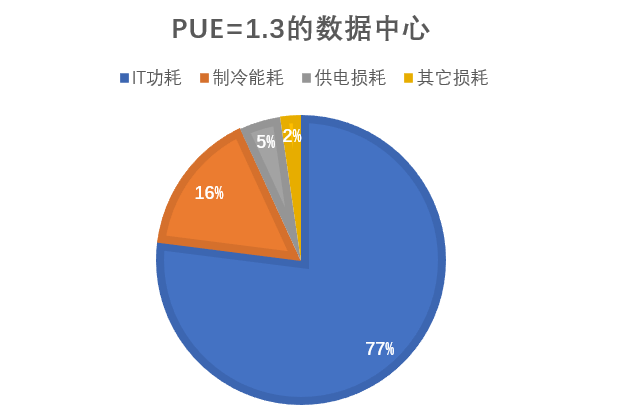

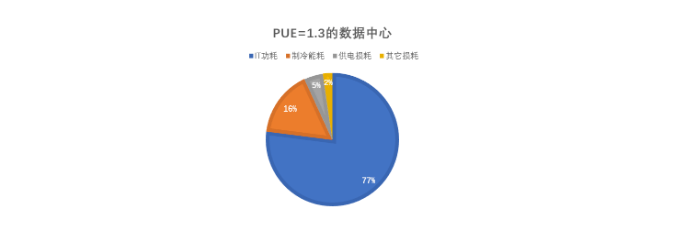

数据中心的PUE能否做到更低,直接因素是制冷的功耗,制冷系统能否节能的关键在于是否有效的利用自然冷源,充分利用自然冷源也是降低制冷能耗,减少制冷碳排放最直接的方案。所以目前大型数据中心在建设时,都要考虑天然冷源的使用,比如全年气温条件是否满足自然冷却要求,例如乌兰察布全年平均温度是5℃~7℃,宁夏中卫全年平均温度是4℃~18℃,甘肃庆阳全年平均温度是5℃~13℃,山西阳泉全年平均温度是6℃~18℃,张家口全年平均温度是4℃~16℃。这些区域年平均温度都比较适合建数据中心,所以“东数西算”数据中心集群优先选址以上区域。除气候之外,还可以考虑有得天独厚水资源的地方,例如湖北省长江三峡数据中心集群,就是利用三峡的电力提供算力,用三峡的水资源提供空调的冷却。像这样的数据中心集群还有湖南省彬州市东江湖数据中心集群,也是采用东江湖大坝下游的优质水资源作为冷却方案以降低PUE。

目前数据中心主要的自然冷源利用方案有以下几大类:

(一)间接蒸发自然冷却机组方案(AHU)

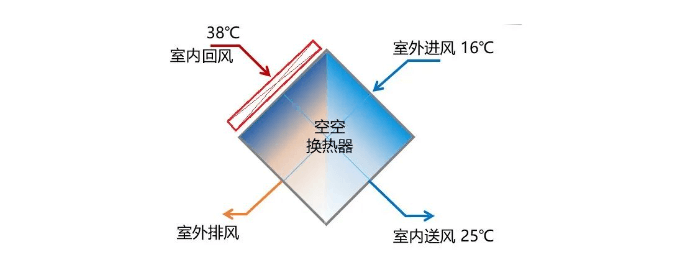

间接蒸发冷节能机组是通过热芯体(空-空换热器)换热器充分利用大气自然冷源实现数据机房散热的设备,室内/外空气无需混合交换即可实现热量传递,最大限度的降低机械补冷使用时长,从而达到节能低碳环保。同时,AHU机组在室外侧利用水蒸发吸热的原理,对室外空气进行喷水(雾),进一步降低室外空气的温度(低于室外环境温度),从而延长室外自然冷源的利用时长,达到节能降耗目的。通常部署在数据中心屋顶或侧边,是新建、改建大型、中大型数据中心的理想选择。

AHU间接蒸发冷却机组方案是整体结构,系统简单。与传统水冷冷冻水系统相比,该机组方案是将冷源设备、输配设备、未端设备、自控系统集成于一体,后期维护非常方便。第二个特点是部署灵活,缩短建设周期。第三个特点是节水节电,可以降低运营成本。该机组方案能够充分利用室外自然冷源,减少压缩机开启时间,运行模式分为干模式、湿模式、混合模式。干模式和湿模式工况下,压缩机不开启。混合模式下,压缩机部分开启。在冬季气温比较低的时候运行干模式,干模式运行时无需喷水。在湿模式蒸发冷却时耗水量低于水冷冷冻水空调系统,传统冷冻水系统的WUE为1.8~2.4之间,而AHU系统方案的WUE为0.3~0.8之间。

(二)氟泵系列自然冷却空调

氟泵技术的发展已经超过十几年,氟泵技术在数据中心的应用是比较常见的技术。目前存在的氟泵空调系统包含:氟泵空调、磁悬浮相变多联空调、PHU整体式氟泵机组、氟泵多联空调等主要的形式。不管什么形式的氟泵空调,其基本原理大同小异,氟泵系统在夏季采用制冷压缩机制冷运行,在春秋过渡季节采用氟泵和压缩机“混合模式”运行,在冬季开启氟泵自然冷却模式,保证全年机房空调安全可靠运行。氟泵系列空调最大的好处就是使用自然冷源,同时可以适用于干旱缺水的场景。

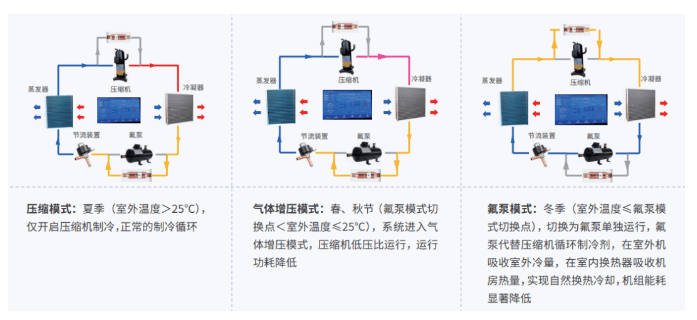

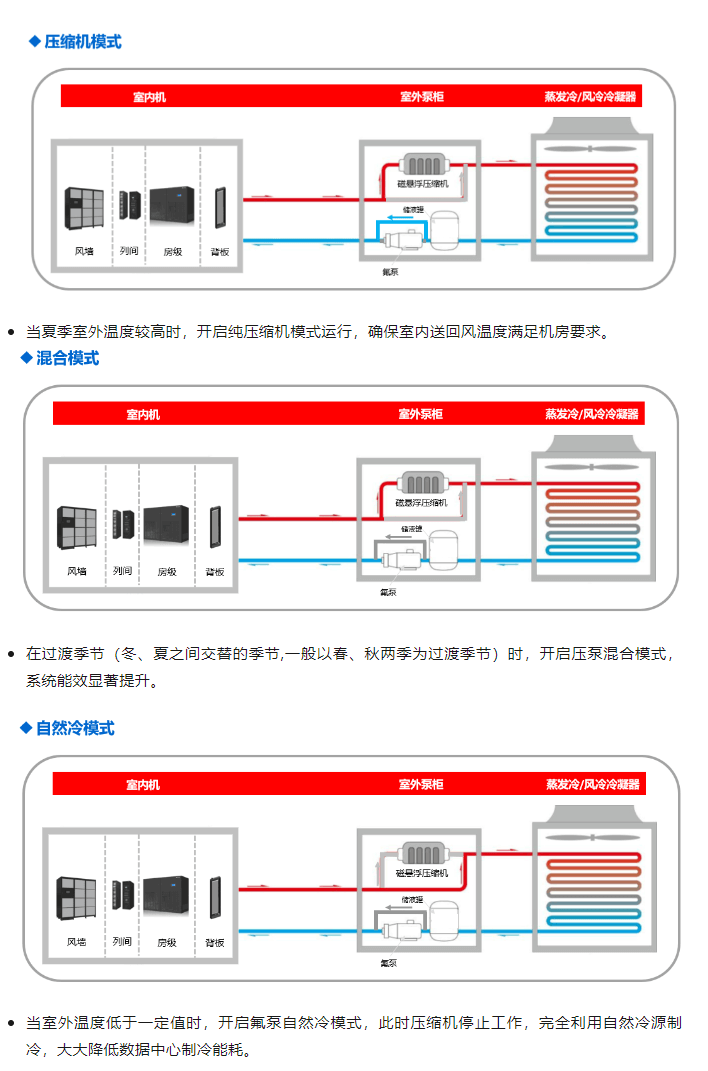

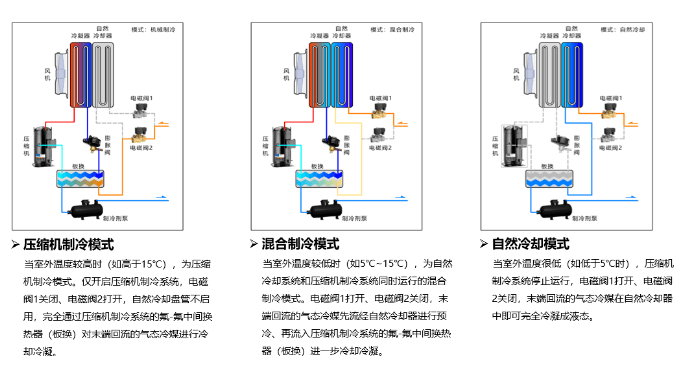

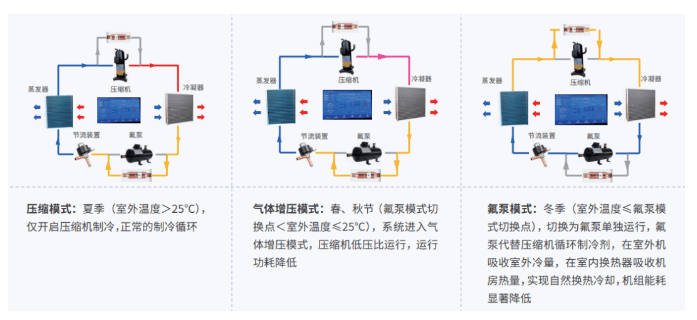

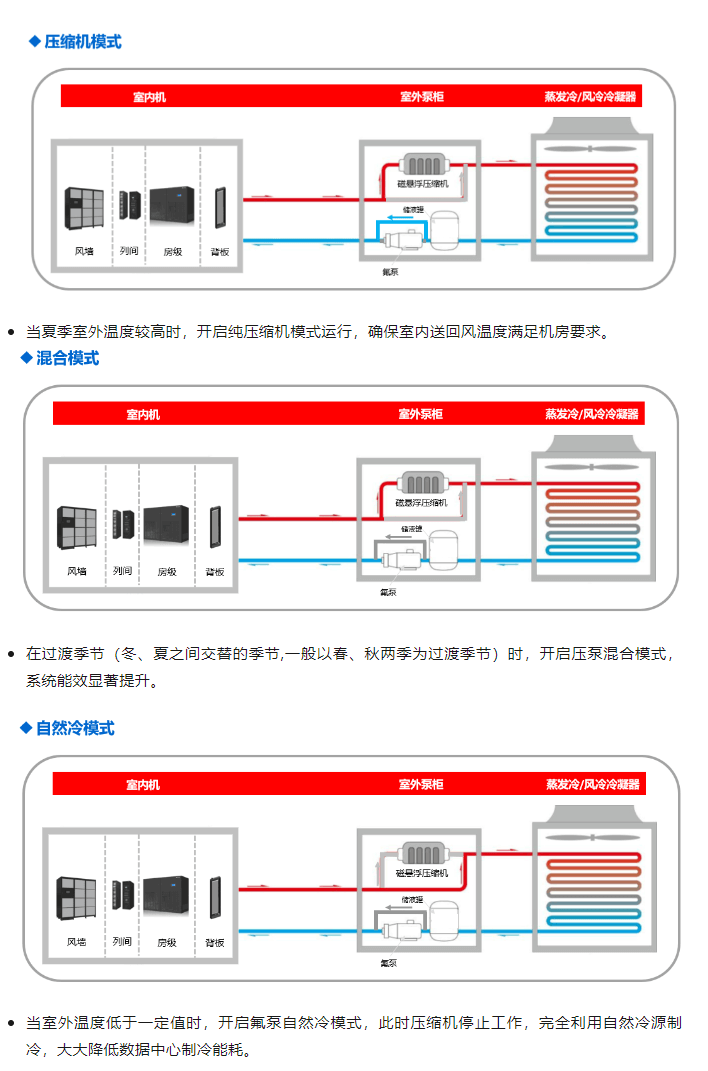

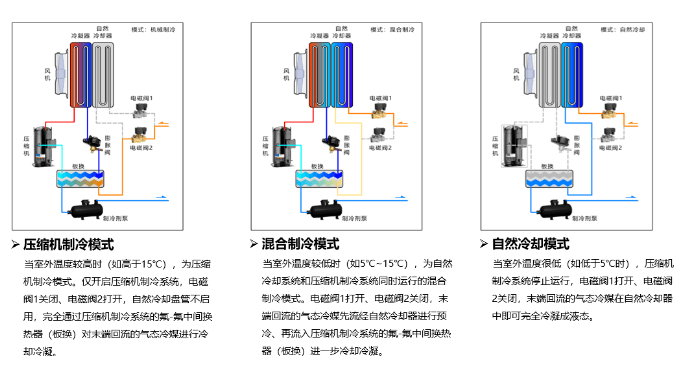

目前氟泵技术最成熟的产品要属气体增压氟泵机组,该方案为室内机和室外机分体设计,配置灵活,适用于各种规模的数据中心场景。氟泵机组系统具有三种运行模式,并最大限度的充分利用室外自然冷源,例如海悟的氟泵机组其运行原理如下:

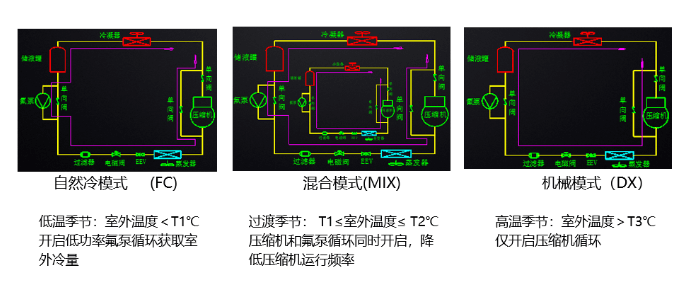

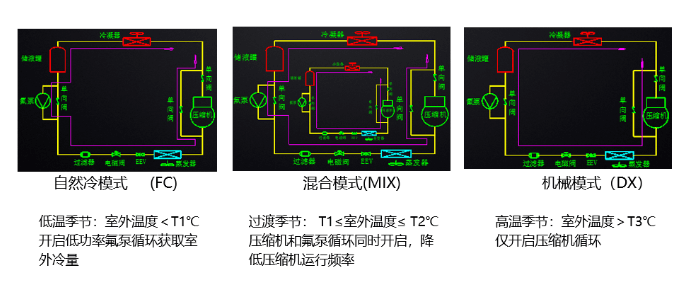

除了分体氟泵机组以外,近几年又兴起了整体式氟泵机组方案(PHU),PHU针对于大型数据中心场景的制冷解决方案。PHU整体式氟泵空调机组是通过低功率氟泵充分利用自然冷源实现数据中心制冷的一体化设备,同样具备三种运行模式,通过对室外环境温度监测自动切换运行模式,能最大限度的提高制冷系统的能效比。例如海悟的PHU机组运行模式如下:

磁悬浮相变多联系统同样具备三种运行模式,例如海悟磁悬浮相变多联系统其运行原理如下:

(三)全时水源自然冷却

利用自然界江、河、湖、海的水源为数据中心提供冷却水,可以不耗费电力制冷,全年几乎大部分时间可以做到水源自然冷,大大降低数据中心全年PUE。

该方案最关键点在于数据中心选址,数据中心需要选在接近自然水源的地方,通过抽取江水或湖水,经过简单的过滤直接作为冷却水使用,因为江水、湖水的温度通常在十几摄氏度,比空气温度低得多,且四季温度波动非常小,可有效地带走服务器产生的热量。具体实现方式是将江水或湖水抽上来经过过滤,然后引入数据中心的冷却水管路,通过板换和数据中心空调冷冻水进行二次换热,冷冻水的回水温度通常是21℃,经过板换后冷却至15℃去空调降温。通过板换的湖水温度升高后又排到江里,从而将服务器等设备的热量转移到江水中,达到冷却的目的。在设计方案时,需要考虑到水源的水质、流速、温度等因素,以确保冷却效果和设备的安全。

采用湖水冷却的数据中心比较有名的是阿里杭州千岛湖数据中心,该数据中心采用深层湖水,数据中心外部有两台湖水处理器,通过密封管道从湖面下35米深处取水,水温基本维持在10度左右。经过缓冲池进入湖水处理器,然后再进入数据中心,通过板换和冷冻水进行换热,帮助服务器降温,经过板换带出热量后,再流经2.5公里的青溪新城中轴溪,作为城市景观呈现,最终流回到千岛湖。该数据中心年平均做到了PUE1.3。

采用长江水冷却的案例比较有名的是湖南省资兴市东江湖数据中心。东江湖数据中心利用东江湖水库大坝下游的江水作为自然冷源,大坝下游的江水温度常年8~13℃,且江水流稳定且水质达到国家一级标准,经过滤处理后进入能源站,通过板式换热器制取冷冻水为机房降温。江水在换热后经密闭管道排入下游,整个过程不消耗水资源且不对江水水质造成影响。这种冷却方式可以降低数据中心的能耗,相比传统的制冷方式,仅需五分之一的能耗即可保障设施的正常运行。东江湖数据中心在全年99%的时间里都完全利用江水源冷却,全年几乎不启动冷水机组。采用江水全时冷却,年平均PUE为1.15。

三、液冷技术方案的应用

创新技术是推动数据中心节能减碳的核心动力、制冷方式的革新、设计建设方式的优化。在数据中心领域,服务器的数量决定了整个数据中心的业务处理能力,而中大型数据中心服务器都是以数千台来计算,按照一个机架放置10台服务器,大型数据中心就需要数百个机架。这样巨量的服务器设备同时运转,按照每台运行功率300W来计算,一万台就要3兆瓦,所以如果每台服务器都能节省一点能耗,一万台服务器节省的能耗就非常可观。因此有不少的专家从服务器入手,在服务器上下功夫,在不降低服务器运行性能的前提下,尽量降低运行的能耗和改善服务器的运行环境,在这样的迫切需求情况下,更加高效的系列液冷方案就应运而生。液冷的冷却能力远远高于传统风冷的冷却能力,同体积的空气和水相比,比如1个立方的水和空气,在常温下温度变化1℃时,空气的传热大约是1.3千焦, 而水的传热大约是4200千焦,可见水的传热能力超过空气的3000倍多。

目前,我国液冷数据中心还处于快速发展阶段,但已经部分大型企业和机构开始尝试部署液冷技术,如阿里巴巴、腾讯、华为等公司都在新建或改造部分数据中心为液冷数据中心。此外,还有一些创业公司也在液冷领域进行探索和实践,如云酷智能、绿色云图、依米康、海悟、申菱等。

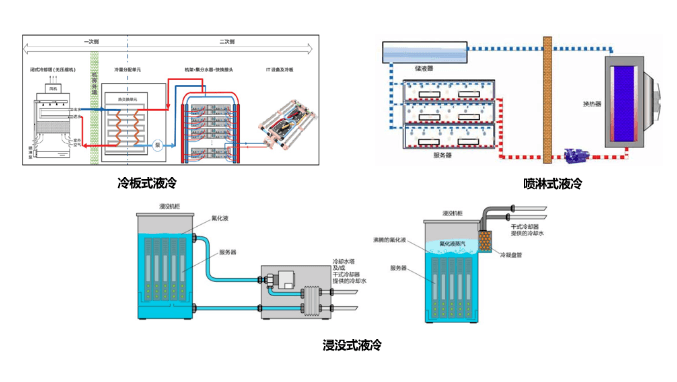

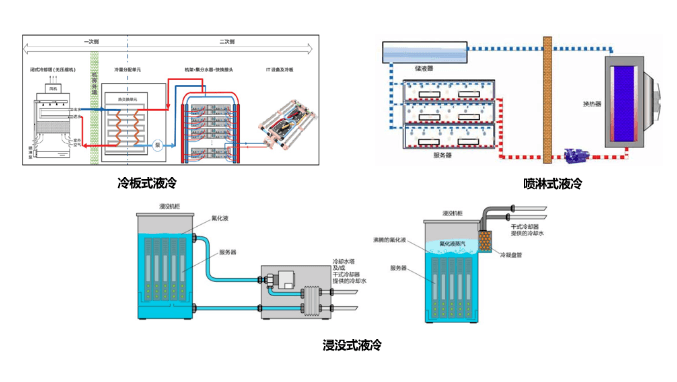

目前液冷技术主要有三大类,分别是喷淋式液冷、浸没式液冷、冷板式液冷,其示意原理图如下:

1. 喷淋式液冷:将冷却液通过喷淋的方式淋在服务器的散热元件上带走服务器产生的热量。

2. 浸没式液冷:将服务器的发热元器件完全浸没在冷却液中,通过冷却液的对流或相变将服务器的热量带走的散热系统。根据目前主流氟化液的单相换热能力是同体积空气换热能力的1200倍以上。如果采用相变浸没式,氟化液的相变换热能力是同体积空气换热能力的10000倍以上。

3. 冷板式液冷:在服务器的CPU等大功耗部件采用液冷冷板散热,其他少量发热器件(如硬盘、接口卡等)仍采用风冷散热系统。冷板液冷优点是对现有机房的架构影响不大,采用水的散热能力是同体积空气散热能力的3200倍,而且具备低噪音、空间利用率高、热能可回收的特点。

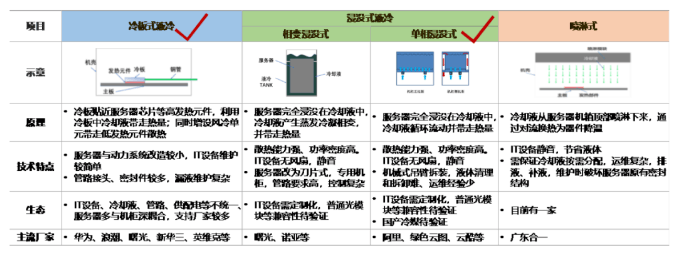

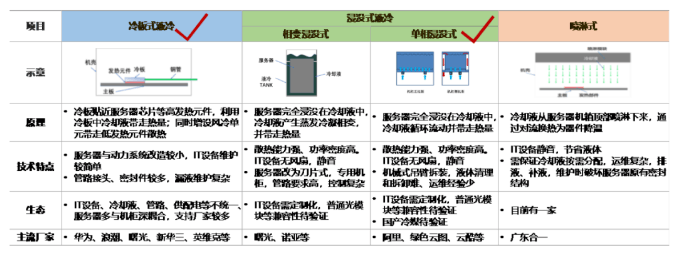

其中,冷板式液冷技术开发较早,是目前成熟度最高、行业布局最多、应用最广泛的液冷散热方案,根据CCID前瞻产业研究院的调研数据,2022年我国液冷市场规模约为600亿元左右,其中冷板液冷的市场份额约占65%,浸没式液冷约占34%,2023年我国液冷市场规模将增至800亿元,到2025年我国液冷市场规模预计将达到1300亿元左右。

2018年,阿里建设了大型浸没液冷张北数据中心,该数据中心是阿里云首个应用全浸没式液冷服务器的数据中心,与传统制冷系统相比,热传导效率要高百倍,节能效果超过70%。阿里张北液冷数据中心不仅在技术上具有创新和领先优势,同时也注重环保和节能。该数据中心采用自然冷却等先进节能技术,可将电能利用效率(PUE)控制在1.25以内,最低可达1.13。

浸没液冷技术的优势不仅在于导热散热,还能够容纳更多IT设备,提高了计算能力。阿里张北液冷数据中心功耗密度达到60千瓦,将计算密度提升了10倍。同时,液冷机柜具有高密封性特点,使得电子元器件远离湿度、灰尘、振动的影响,提升了设备的稳定性、降低了故障发生率。阿里张北液冷机房运行3年来,与同等规模的其他机房相比,故障发生率降低了54%。基于阿里对张北液冷数据中心的经验,2020年阿里又在杭州建设了中国首座绿色等级达5A级的液冷数据中心—阿里杭州仁和液冷数据中心,该数据中心整栋楼采用了全浸没液冷服务器。由于大规模使用全浸没液冷服务器技术,使得整体PUE值为1.09,达到目前世界最领先水平。

2023年6月5日,移动、联通、电信三大运营商在第31届中国国际信息通信展览会“算力创新发展高峰论坛”上发布了《电信运营商液冷技术白皮书》,白皮书分析了数据中心目前面临的形势和液冷技术发展现状,介绍了电信运营商液冷技术实践和目前的发展挑战,提出电信运营商液冷技术发展三年愿景和具体技术路线,对冷板式和浸没式液冷两种型式关键技术选择做了介绍。总体来看,冷板式液冷与单相浸没式液冷各有优劣,生态均需完善,两者演进均尚需时日,未来一定时间内将并存发展,为当前业内发展主流。综上,电信运营商现阶段主要推进冷板式液冷与单相浸没式液冷两种技术路线,详细如下:

根据《电信运营商液冷技术白皮书》,预计到2025年50%以上数据中心项目将应用液冷技术。互联网行业液冷数据中心占比达24.0%,金融行业占比达25.0%、电信行业占比达23.0%、能源行业占比达10.5%,生物、医疗和政务等行业需求将加快融入通用数据中心新业态。

液冷技术的出现,不但为“双碳”战略做出了贡献,同时也推动了数据中心节能新技术的落地,改善了传统风冷的散热形式,更能满足高密机柜、芯片级精确制冷、更节能、更节地、更低噪声。

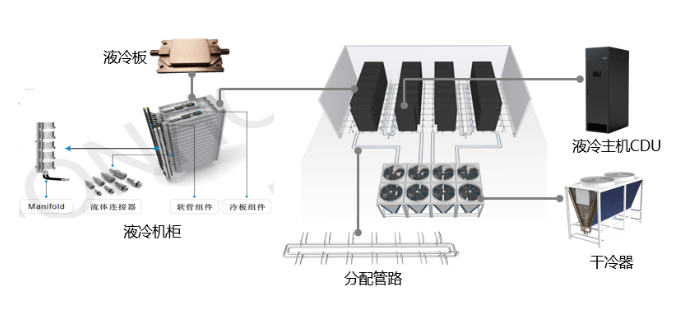

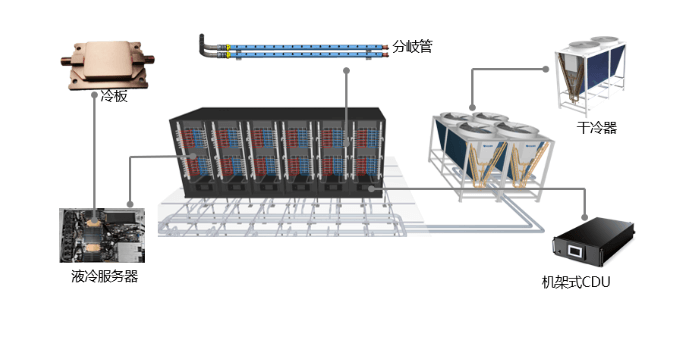

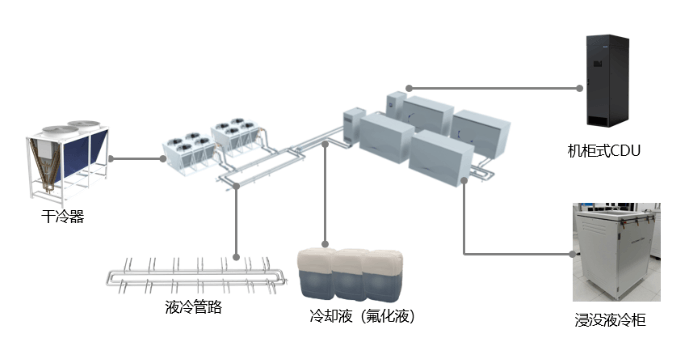

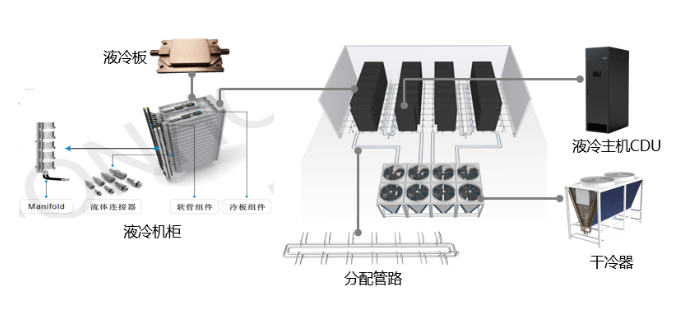

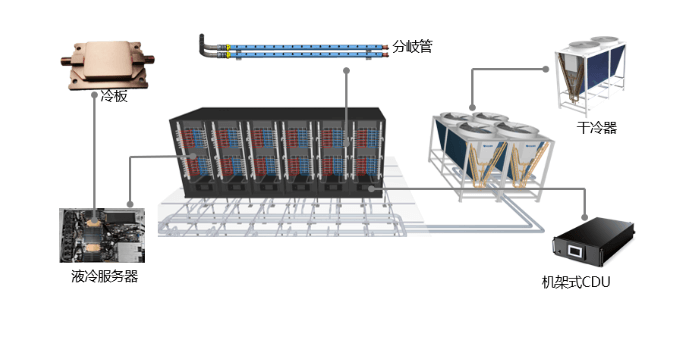

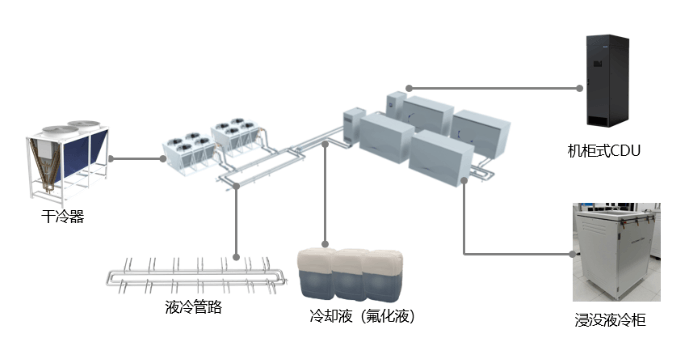

液冷方案在实际数据中心场景应用中,结合不同的产品制定了场景化的解决方案,例如海悟的场景化液冷解决方案,分别是:

场景一:采用冷板式液冷,配合集中式CDU解决方案,该方案最大支持的功率密度为50~80kW,整体液冷方案年平均PUE可以做到1.2及以下。

场景二:此方案采用冷板式液冷,配合分布式CDU方案,该方案最大支持功率密度为50~80kW,整体液冷方案年平均PUE同样可以做到1.2及以下。

场景三:此方案采用单相浸没式液冷,室外采用干冷器,配合双机柜式CDU,最大支持功率密度为30~100KW,整体液冷方案年平均PUE可以做到1.1及以下。

目前各液冷设备厂家的方案有所不同,因为液冷技术当前生态不完善,各家产品形态各异,产品规范化程度较低,机柜与服务器深度耦合,尚无统一接口标准,难以标准化、规模化推广应用。推广液冷技术,需集思广益、凝聚共识,完善液冷产业标准化和生态建设、促进液冷技术有序发展,开辟数据中心液冷行业高质量发展道路。

四、热回收方案的应用

随着“双碳”政策的推进,更多的数据中心从业者把目光锁定在数据中心余热上,数据中心在运行过程中产生的中低品位余热,这些余热是一种优质热源,可以用于加热生活用水、供暖,在帮助用户降低用热成本的同时,也可间接减少因使用化石燃料产生的二氧化碳。根据现有数据,我国北方地区数据中心的可回收余热总量约10GW,理论上可支持3亿平方米建筑供暖。目前,一些大型数据中心已经采用了数据中心余热回收技术,如阿里千岛湖数据中心、腾讯天津数据中心、中国电信重庆云计算基地、万国数据北京三号数据中心和Ucloud乌兰察布云计算数据中心等。采用余热回收给园区供暖和热水的技术不仅可以减少能源的消耗,还能降低数据中心的运营成本,可谓是一举两得。

目前采用余热回收的主要方案包括以下几种:

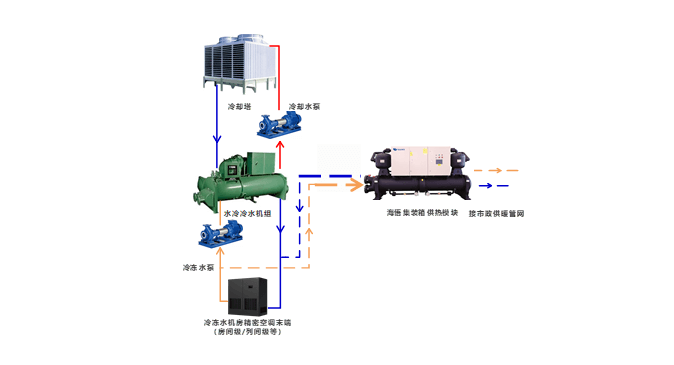

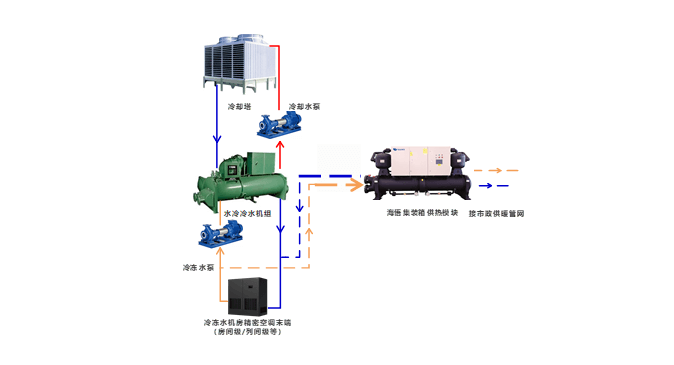

(一)冷冻水型机房空调系统的余热利用

冷冻水型机房空调系统制冷流程为:冷冻水泵将机房内的热量通过水循环带入冷机蒸发器,压缩机在电力驱动下将蒸发器吸取的热量传递给冷凝器,冷却水泵推动水循环将冷凝器的热量换取并带入冷却塔,冷却塔通过直接或间接的方式将循环水内的热量通过强制换热散发到室外环境中去。如此往复循环。

冷冻水型机房空调系统通常全年能源效率较低,一般多采用冷冻水侧余热回收,系统原理如下:

余热回收利用主要发生在冬季,通过余热回收机组进行热回收,进而为周围建筑物供暖。

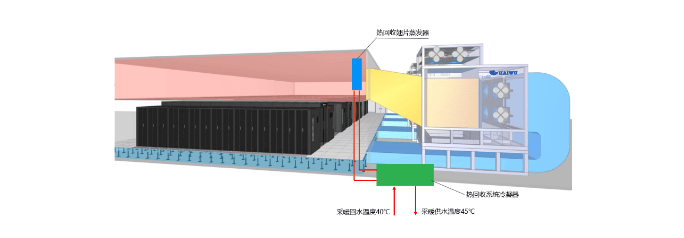

(二) AHU空调系统机房回风余热回收

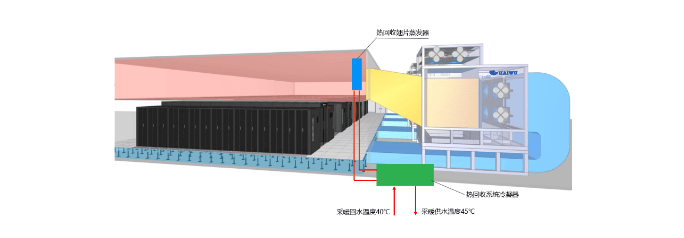

AHU空调系统是一种被大型数据中心机房广泛采用的温控方式,尤其是在北方地区,能很好的利用自然冷源,大幅降低全年运行PUE。其余热回收原理见下:

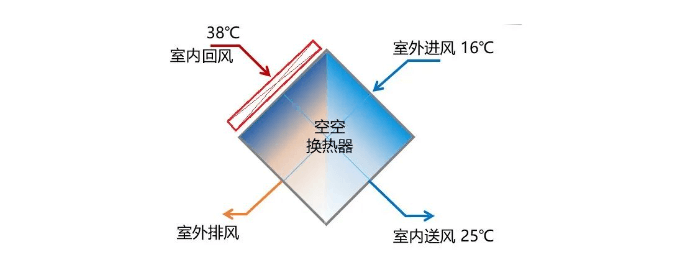

此处(AHU机组换热芯体室内回风侧)热量品位较高,回收效果最佳。然后,再过AHU机组中的空-空换热器与室外空气换热,此时AHU可根据室内回风温度自动调节进入空空换热器的室外冷风。

经结合海悟AHU产品的运行参数进行测算,该热回收方式只要在机房回风腔加装翅片蒸发器,回风进回热蒸发器的温度38℃,出蒸发器的温度26~28℃,可利用温度达到10℃以上,而翅片风阻最高仅增加40Pa左右,造成的AHU风机总功耗增加约0.85kW,但海悟余热回收热泵在此工况下的运行COP却可以达到6.31以上,使得四季制取45℃热水的单位耗能都可以降低到传统电暖设备的1/6以下,如充分加以利用,将取得非常好的经济和社会效益。

(三)海悟PHU全天候节能机组热回收

PHU机组本是在“严控PUE、WUE”政策压力下诞生的,开发理念里自带节约、增效、环境友好的基因。其中,海悟出品的带热回收的PHU机型,是2022年新推出的“能源技术与信息技术融合型产品”,是为了推动行业向着“构建绿色、低碳数据中心”为目标的正确方向上发展而做出的努力和贡献。

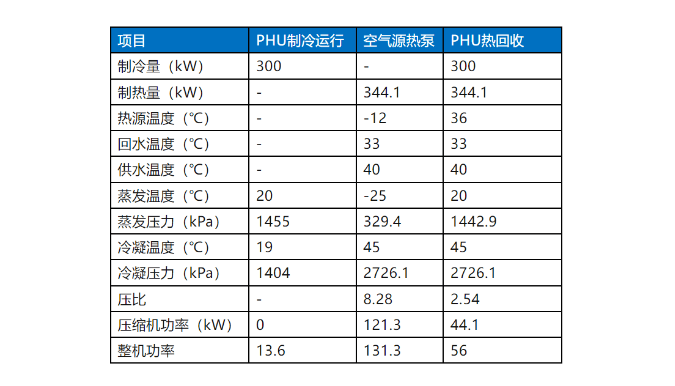

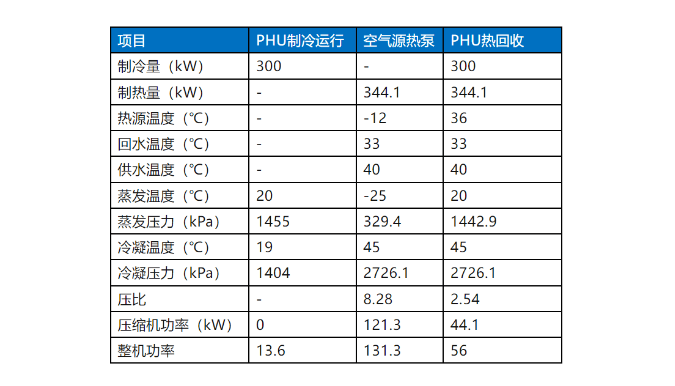

在冬季采暖季节, 海悟PHU热回收机组可维持更高的蒸发温度,利用小压比压缩机,以极致的的效率产出热能,整机制热能效比空气源热泵机组有显著提升,从下面的对比表里可以一探端倪:

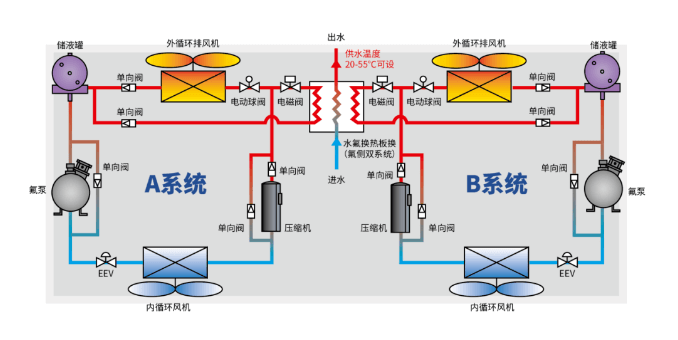

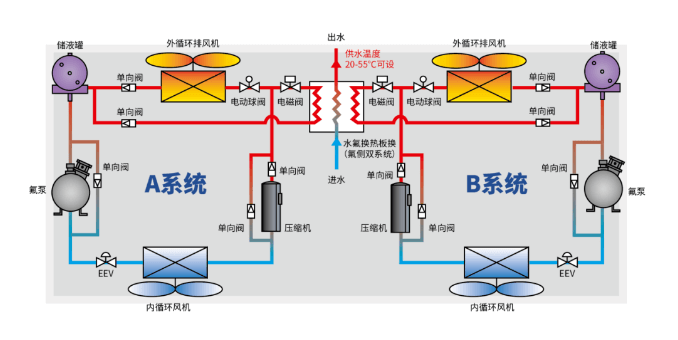

在压缩机排气管路上并联一个热回收模块(水氟换热板换),通过电磁阀来控制热量的流向控制,回收排气热量,提供采暖热水。通过电磁阀与电动球阀调节整机供热量。A/B系统分级切入/切出热回收工况,避免水温剧烈波动。

(四)液冷数据中心方案中的余热回收

前面展示的三种典型的数据中心余热回收利用技术,其共同的特点是:余热回收利用占全年总排热的比例还很低,热量利用的形式都是低温的热水,用途也受限于洗涤、供暖、养殖、印染……等较小的领域。由于低温热水的传输半径极其有限,一般受管网及泵送成本的制约,仅能覆盖在2-3公里范围内,而数据中心的选址有特殊需求,周边大概率缺少合适的热量用户,造成供需双方的可望而不可及。

现在也有在探索冷板或浸没式液冷方案中的热回收,比如冷板液冷方案中,冷板液冷通常的出水温度最大45℃,直接在冷板的出水管增加水源热泵机组,以此来制造出较高温度的热水,但这种方案对热利用的效率仍然不高。如果在芯片的温度上考虑是否可以提高冷板液冷的出水温度至65℃,甚至更高一些,通常芯片内部最大能承受的温度不超过80℃,如果能提升冷板的出水温度至65℃,这对于热回收来说直接利用余热的用处更广泛。浸没式液冷也同样,如果能提升浸没液体的温度,对于热回收的使用价值更大。

总之,数据中心的余热回收在整个行业还处在摸索阶段,目前供暖对象比较单一,与相关行业合作不多,规模还需进一步扩大,相关技术还需进一步完善,热能利用率还需进一步提升。在这个领域,数据中心的发展远远没有达到预期的水平。数据中心的热到哪里去了?值得我们所有数据中心从业者考虑和研究,希望在余热回收方面能为“双碳”战略做得更多。

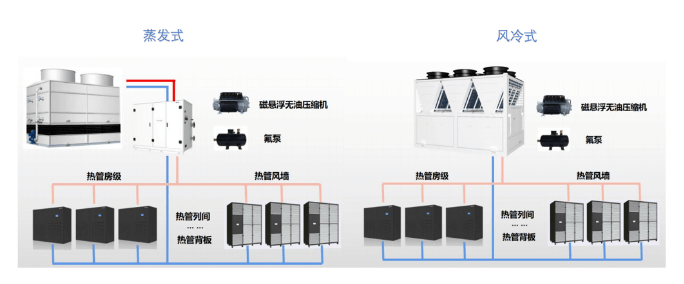

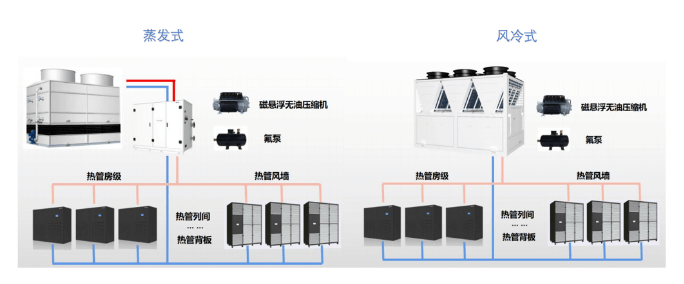

除了分体氟泵和整体式氟泵PHU以外,针对大型数据中心场景,并对PUE有着极高要求的场景(例如:PUE≤1.2),可以采用磁悬浮相变多联系统,该系统主要应用了磁悬浮变频技术、蒸发冷凝器技术、变频氟泵技术、末端多联技术等。目前主要的冷却形式有磁悬浮蒸发多联系统和磁悬浮风冷多联系统。

除了以上三种形式的氟泵系统方案以外,为适配室外机安装空间有限的数据中心场景,于是氟泵多联机系统运应而生,即由一个室外机拖多个室内机的氟泵系统,简称氟泵多联机。氟泵多联机同样具备三种运行模式,例如海悟氟泵多联其运行模式如下:

从机房出来的38℃热风流过为余热回收而增设的热泵机组的蒸发器,温度被降低到26~28℃,气流原理如下:

将数据中心制冷与办公区域采暖集成于一体,最大限度的实现能源的综合利用。其热回收原理如下:

获取最新价格?我们会尽快回复(12小时内)